+49 30 533206 – 570

Projekte-Hotline: +49 3327 5658 – 28

info@digitalzentrum.berlin

Projekte-Hotline: +49 3327 5658 – 28

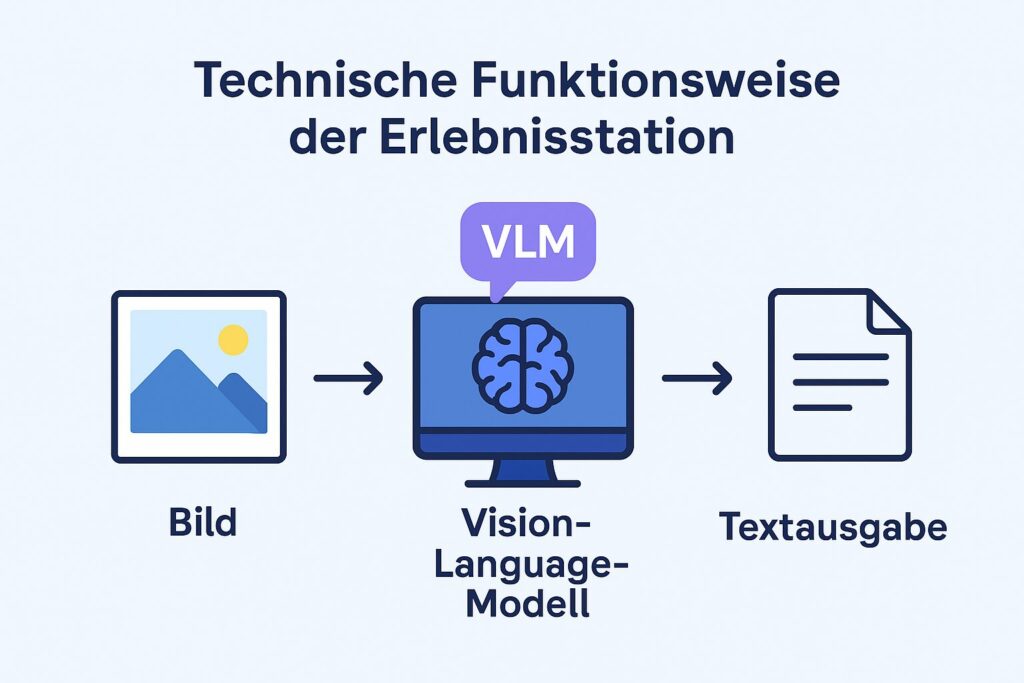

Die Erlebnisstation „Describe Everything“ ist ein Demonstrator für Vision-Language-Modelle (VLM). Sie zeigt beispielhaft, wie Künstliche Intelligenz Bilder analysieren und in verständliche Sprache übersetzen kann.

Nutzerinnen und Nutzer laden ein Foto hoch und wählen zwischen drei Detailstufen:

So erleben Besucher:innen direkt, wie aus reinen Bilddaten strukturierte Informationen werden – und wie der Detaillierungsgrad den Nutzen und die Lesbarkeit verändert.

Die KI-Technologie der Smart Sketch Search hat zahlreiche praktische Anwendungen für Unternehmen

Kurzfassung: Versicherer und Dienstleister lassen Fotos von Schäden (Fahrzeuge, Gebäude, Waren) automatisiert analysieren. Die KI identifiziert Schadensarten, schätzt Ausmaß/Kostenklassen, erzeugt standardisierte Befunde und priorisiert Fälle für manuelle Gutachter. So werden die Bearbeitungszeiten der Schadensmeldungen deutlich verkürzt und die Konsistenz erhöht.

Beispiel: Nach einem Hagelsturm lädt eine Kundin Fotos ihres beschädigten Dachs hoch. Die KI erkennt in Sekunden Bruchstellen, Wasserschäden und verschobene Dachlatten, klassifiziert den Schaden und erstellt automatisch einen Bericht fürs Schadensmanagement. Standardfälle werden direkt bearbeitet, komplexe Fälle gehen an eine Sachverständige – mit allen Bildauswertungen im System. Das beschleunigt die Bearbeitung, reduziert Rückfragen und schafft Freiraum für Fälle, die menschliche Expertise erfordern.

Wenn Sie Bilder auf Ihrer Website oder in sozialen Medien veröffentlichen, bleiben diese für blinde und sehbehinderte Menschen ohne Beschreibung unsichtbar. Vision-Language-Modelle können automatisch kurze oder detaillierte Textalternativen erstellen, die Screenreader direkt vorlesen. So erfahren Nutzerinnen und Nutzer, was auf dem Bild zu sehen ist – von Personen und Farben bis hin zu Handlungen.

Für Sie bedeutet das:

Zugänglichkeit ohne Zusatzaufwand – Beschreibungen entstehen automatisch.

Rechtssicherheit – Sie erfüllen gesetzliche Vorgaben zur Barrierefreiheit.

Flexibilität – Texte lassen sich je nach Kontext kürzen oder erweitern.

Im Vergleich zu manueller Texterstellung ist die KI-Lösung schneller, skalierbarer und konsistent in der Qualität.

Textinhalte können von Suchmaschinen indexiert werden – Bilder allein nicht. Automatisch generierte Beschreibungen erhöhen so die Auffindbarkeit. Und Kunden können Produkte über Suchbegriffe oder Filter finden, die auf den Textbeschreibungen basieren, z. B. „rotes Sommerkleid aus Baumwolle“.

Es sind unterschiedliche Kostenmodelle für VLM-basierte Bildanalyse möglich:

Das VLM erreicht eine Genauigkeit von ca. 85-90% bei der Objekterkennung und kann komplexe Szenen meist korrekt beschreiben. Gelegentlich können Details falsch interpretiert oder übersehen werden.

Showroom besuchen.

Sie möchten die Erlebnisstation selbst ausprobieren? Gerne laden wir Sie in unseren Showroom ein oder zeigen die Station auf Ihrer Veranstaltung oder Messe. Für Anfragen erreichen Sie uns per E- Mail: info@digitalzentrum.berlin.